【论文复现】Restormer

摘要

因为transformer太大了,本文就设计了一个新的方式计算transformer,和新的transformer block使其复杂度降低成$O(C^2WH)$的同时刷新了sota。

方法

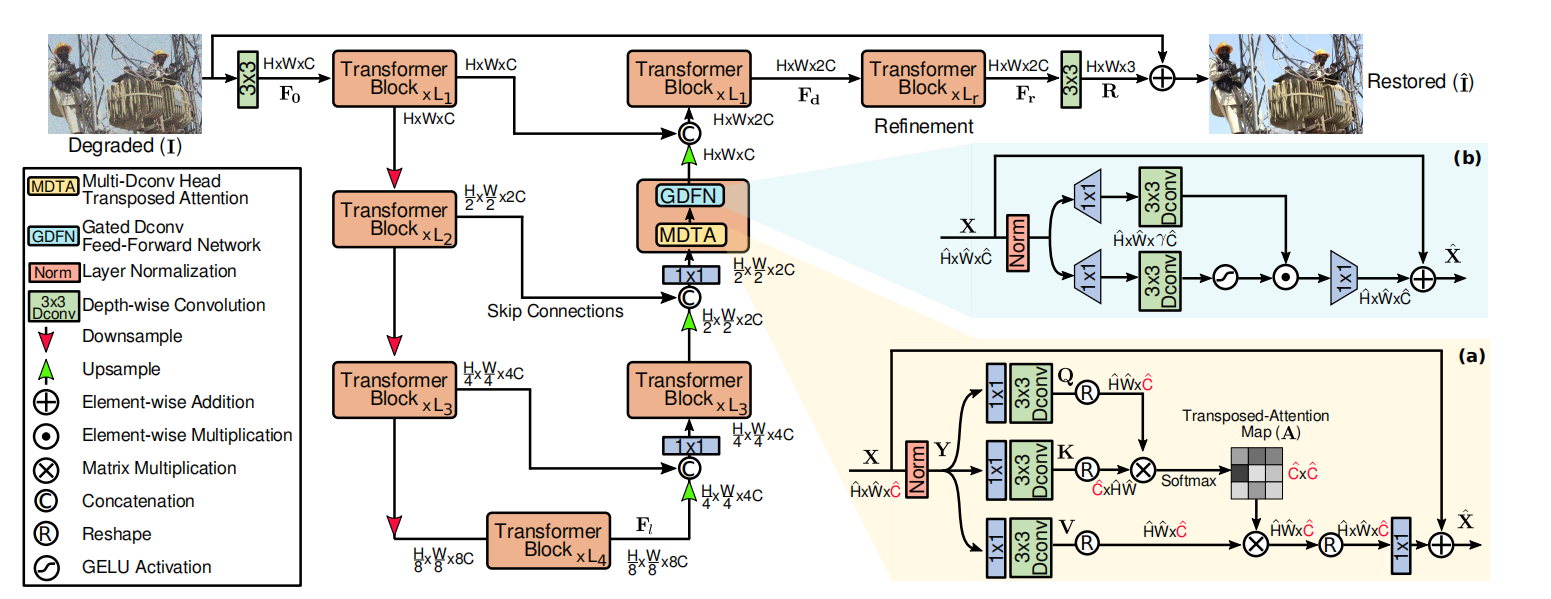

网络结构

创新点主集中在transformer block:

GDFN(gate de-conv feedforward network):

这部分由gate(gelu)+dwconv+1x1 conv组成,这个门似乎是灵光一闪出来的,凑创新点。

MDTA(muti-head de-conv transpose attention):

这个论文里面说的很nb,仔细看就发现他是相当于把矩阵转置然后再乘,原本的$HW^2$就变成了$C^2$,个人感觉这个东西挺好想的,但是为什么没人做呢。

进化学习

前面说其他transformer用了patch对图片空间性不好,对于图像重建不友好等等,我还以为他把patch去掉了,结果只是越往后patch size越大来搞,唬人。

这个idea和fine tune很像,首先训练2x放大,再训练4x放大,这样训练出的网络会更好。可以借鉴一下思想。

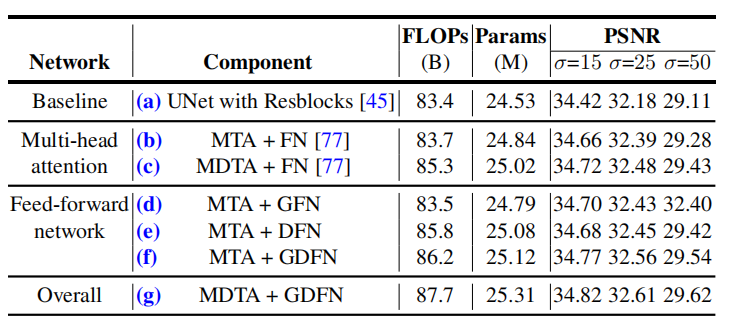

消融实验

就说一下比较关注的GDFN和MDTA,其他的像progressive learning和加深网络什么的我觉得没有什么好讲的。

如下图:

可以发现MTA+GFN是不如MTA+FN的但是MTA+DFN却有很大增长,同样MDTA+FN比MTA+FN也有很大增长,相比之下gelu的效果就没有那么明显,说明这个dwconv非常重要(或者是加了一层conv效果显著?这个应该也有个对比实验),这可以思考借鉴一下。

后记

- GDTA:dwconv的效果比门gelu提升更明显,更有借鉴意义?。

- MDTA:文章明明强调了attention的优化,但是对比实验里面却没有着重对比速度,flops之类的,只有摘要旁边的那个图,就很迷惑。

- progressive learning可以记一笔。

本文作者: dummerfu

本文链接:https://dummerfu.top/p/49081.html

版权声明: 本博客所有文章除特别声明外,均采用CC BY-NC-SA 4.0许可协议 转载请注明出处!

本文链接:https://dummerfu.top/p/49081.html

版权声明: 本博客所有文章除特别声明外,均采用CC BY-NC-SA 4.0许可协议 转载请注明出处!

Comment