【论文复现】SwinIR

前言

好久没更博客了,这次就爆肝两篇。

摘要

原来的图像重建都很少基于transformer如IPT和VSR-transformer但是这两个都是patch-wise对图像重建不是很合适,这篇文章借鉴了swin transformer的架构并且参数量更少,还能提点也不是patch-wise(但是看后面也没有着重强调这一点)。

方法

网络架构

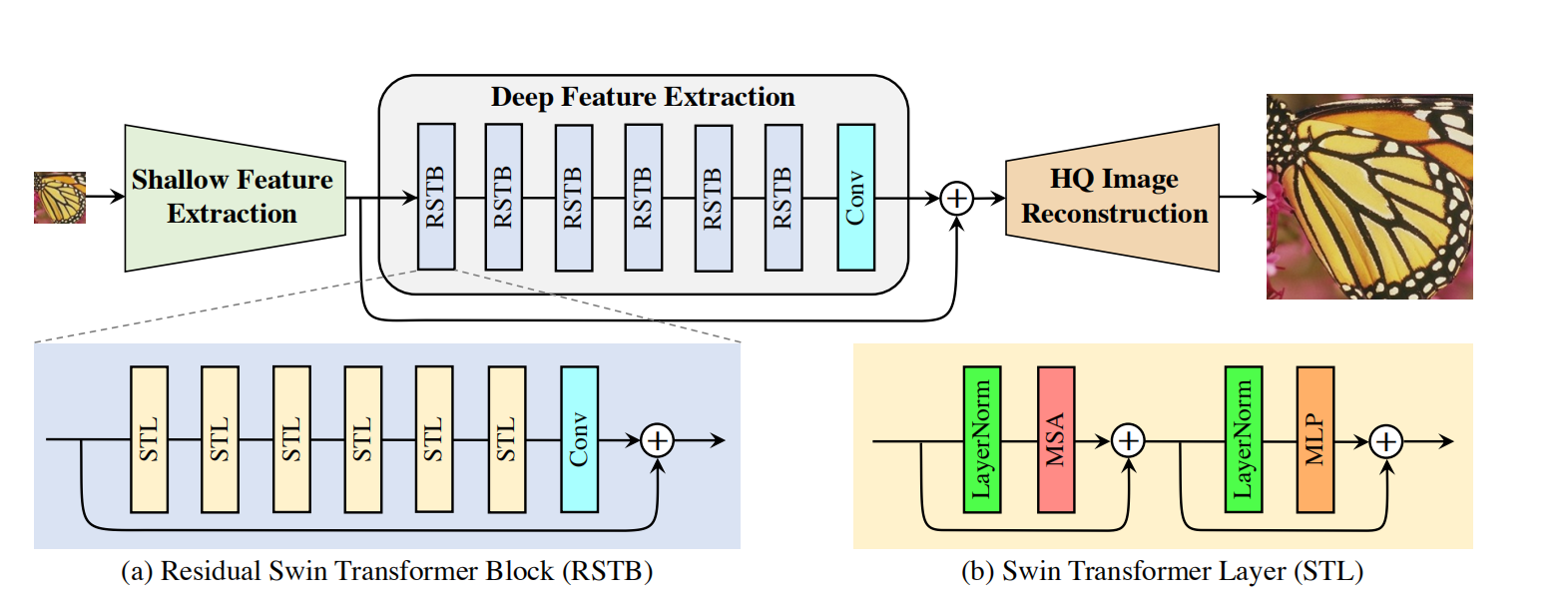

网络包括浅层特征提取+深层特征提取+图像重建模块,如下图:

对于不同的任务,图像重建模块不同,但是浅层和深层模块都一样:

浅层模块就是一个3X3卷积,深层模块是k个有shortcut 的swin transformer的堆叠,最后也是加一个3X3卷积层。

但是对于任务不同,图像重建模块是不同的:

- 图像超分:因为最后要上采样,所以要加一层sub pixel。

- 图像去噪,jpeg去伪影:就是单纯的一层卷积层(也没有说是什么卷积层)。

文章还解释了一下几个创新点:

- 为什么要在外层加入short cut:因为深层特征提取会忽视低频特征,留下高频特征,用shortcut可以最后加入低频特征。

- 为什么内层RSTB也要有short cut:shortcut能聚合不同层次的特征

因为short cut nb - 为什么RSTB里面需要一层卷积层:transformer可以看作空间变换的一个特例,但是卷积具有空间滤波不变性能增加平移方差。(不是很懂这个理论)

loss

同样,对于不同任务的loss也不同:

- 图像超分:经典的和轻量级的图像超分直接用L1 pixel loss,现实图像超分使用pixel loss+gan loss+percep loss

- 图像去噪:使用charbonnier loss

消融实验

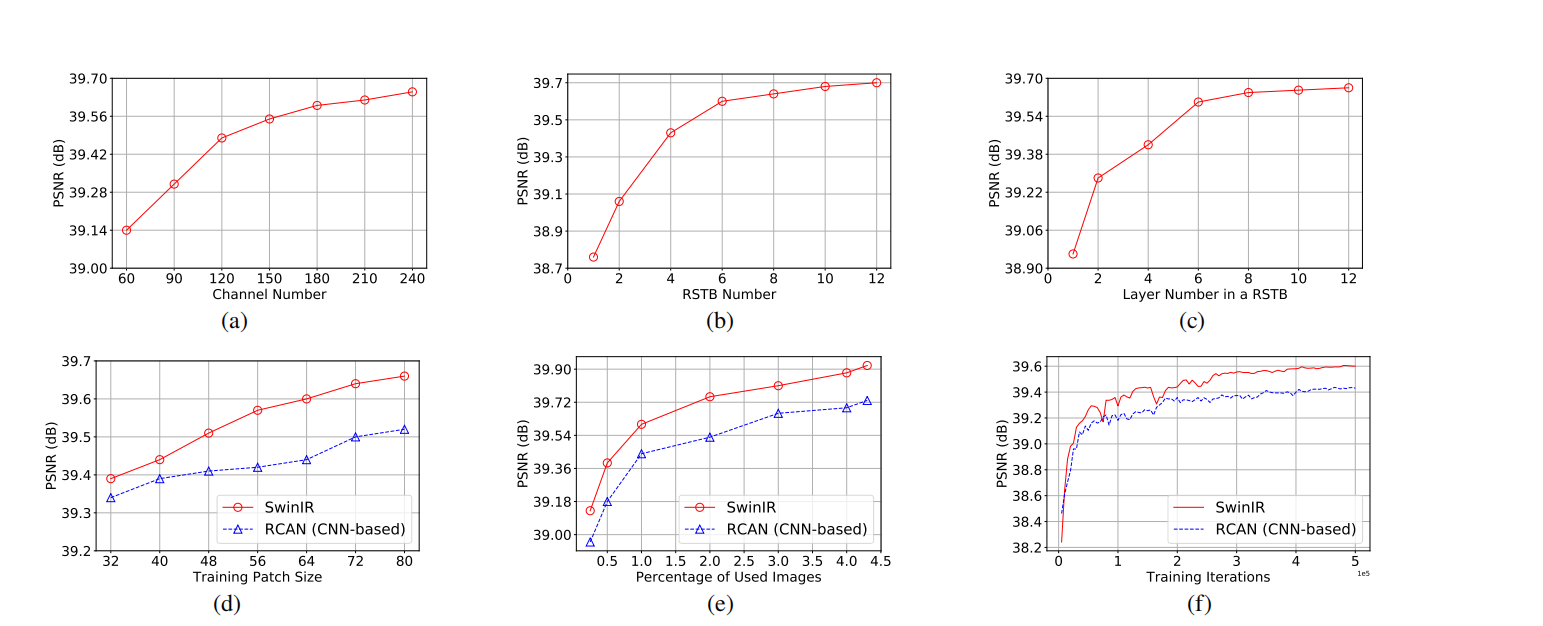

具体实验结果图如下:

- 3X3卷积的通道数:与PSNR呈正比,论文取180。

- RSTB数量:与PSNR成正比,论文取6层

- STL数量:与PSNR成正比,论文取6层。

- RSTB中的卷积层:在有short cut的条件下尝试了1x1,3x3和三个3x3,发现一个3x3效果最好,因为1x1没有提取到图像邻近信息,文章没有说为什么3个3x3效果会变差。

- RSTB中的short cut:去掉short cut 下降了0.16db。

后记

读完这篇论文,感觉只有trick 又多了一个,这篇似乎只验证了short cut的可行性,平均比sota高0.3%。

ensemble-strategy

这个分为epoch ensemble strategy和self ensemble strategy:

- epoch ensemble strategy:取两次不同的epoch对同一张图片进行测试对结果求平均。

- self ensemble strategy:对一张图片进行水平反转+垂直反转+原图+水平垂直翻转,测试后再转回去取平均。

卷积的空间平移方差增大

感觉是翻译问题,我找了半天最接近的应该是translation equalvariance? ,意思是平移卷积和卷积平移的结果不变,公式上来表示就是:$f(g(x))=g(f(x))$,这是cnn的一个现验条件之一(另一个现验条件是cnn卷积时相邻信息相关性强)

本文作者: dummerfu

本文链接:https://dummerfu.top/p/3640.html

版权声明: 本博客所有文章除特别声明外,均采用CC BY-NC-SA 4.0许可协议 转载请注明出处!

本文链接:https://dummerfu.top/p/3640.html

版权声明: 本博客所有文章除特别声明外,均采用CC BY-NC-SA 4.0许可协议 转载请注明出处!

Comment